Klasterisasi Data

Klasterisasi data menggunakan KMeans merupakan algoritma yang sangat populer karena kemudahannya. Data akan dikelompokkan berdasarkan kedekatan masing-masing titik data pada titik beratnya. Secara umum, data yang jaraknya dekat biasanya mempunyai kesamaan yang lebih besar daripada data yang jaraknya jauh. Jarak antar data biasanya diukur menggunakan Eucledian Distance.

Klasterisasi data KMeans di Python dapat dilakukan dengan mengimpor pustaka KMeans dari scikitlearn cluster

Diagnosis dan deteksi dini kanker payudara dengan mendiagnosis massa payudara dari Aspirasi Jarum Halus (FNA) telah dibuat yang memungkinkan diagnosis FNA payudara bahkan oleh pengguna yang tidak terlatih. Sistem ini digunakan di Rumah Sakit University of Wisconsin. Antarmuka grafis dikembangkan untuk menghitung fitur wilayah kecil dari FNA didigitalkan, menghasilkan 640 × 400, 8-bit-per-pixel gambar grayscale. Program analisis gambar, program Xcyt digunakan untuk fitting kurva untuk menentukan batas-batas inti. Sebagian dari gambar yang diproses ditunjukkan pada Gambar 1. Sepuluh fitur dihitung untuk masing-masing inti: luas, jari-jari, keliling, simetri, jumlah dan ukuran cekung, dimensi fraktal (batas), kekompakan, kehalusan dan tekstur. Data diagnosis berisi simbol B dan M yang mewakili Benign/Sehat dan Malignant/Sakit.

Gambar 1: Gambar FNA yang diperbesar dari sel kanker payudara ganas (Munish Puri, et.al., 2013, https://archive.ics.uci.edu)

Koefisien korelasi

dari Wikipedia, ensiklopedia gratis

Koefisien korelasi adalah ukuran numerik dari beberapa jenis korelasi , yang berarti hubungan statistik antara dua variabel . [1] Variabel dapat berupa dua kolom dari kumpulan data pengamatan tertentu, sering disebut sampel , atau dua komponen variabel acak multivariat dengan distribusi yang diketahui .

Ada beberapa jenis koefisien korelasi, masing-masing dengan definisi dan jangkauan kegunaan dan karakteristik masing-masing. Mereka semua mengasumsikan nilai dalam kisaran dari −1 hingga +1, di mana ± 1 menunjukkan kesepakatan terkuat dan 0 ketidaksetujuan sekuat mungkin. [2] Sebagai alat analisis, koefisien korelasi menyajikan masalah-masalah tertentu, termasuk kecenderungan beberapa jenis untuk terdistorsi oleh pencilan dan kemungkinan salah digunakan untuk menyimpulkan hubungan sebab akibat antara variabel.

Nilai 1 pada Data Diagnosis mewakili Malignat sedang nilai 0 mewakili Benign,

Confusion Matrix

Dalam bidang machine learning dan khususnya masalah klasifikasi statistik , Confusion Matrix , yang juga dikenal sebagai matriks kesalahan, [4] adalah tata letak tabel spesifik yang memungkinkan visualisasi kinerja suatu algoritma, biasanya supervised learning (dalam belajar tanpa pengawasan biasanya disebut matriks contingency). Setiap baris matriks mewakili nilai dalam kelas yang diprediksi sementara setiap kolom mewakili nilai dalam kelas sebenarnya (atau sebaliknya). [2] Nama ini berasal dari fakta bahwa membuatnya mudah untuk melihat apakah sistem membingungkan dua kelas (yaitu umumnya salah memberi label satu sama lain).

Ini adalah jenis khusus dari tabel kontingensi , dengan dua dimensi ("aktual" dan "diperkirakan"), dan set "kelas" yang identik di kedua dimensi (setiap kombinasi dimensi dan kelas adalah variabel dalam tabel kontingensi).

Metrik ini merupakan pengukuran simetris: perbandingan label_true dengan label_pred akan menghasilkan nilai skor yang sama. Ini bisa bermanfaat untuk mengukur kesesuaian dua label independen pada dataset yang sama ketika label yang sebenarnya tidak diketahui.

Matriks antara nilai sebenarnya dengan nilai prediksi. Matrix ini serupa dengan Confusion Matrix

Skore bernilai antara 0 sampai dengan 1. Semakin tinggi nilai semakin bagus tingkat kesamaan antara nilai sebenarnya dengan nilai prediksi.

Mempunyai nilai antara 0.0 sampai dengan 1.0. Nilai yang baik adalah nilai yang mendekati 1.0

Skor antara 0.0 sampai dengan 1.0. Skor 1.0 menunjukkan labelisasi homogen

Nilai yang didasarkan pada perhitungan contingency matrix

Skor antara 0.0 sampai dengan 1.0. Skor 1.0 menunjukkan labelisasi total

Nilai paling bagus adalah 1 dan nilai paling jelek adalah -1. Nilai mendekati 0 menunjukkan klaster yang tumpang tindih. Nilai negatif menunjukkan bahwa sampel dikelompokkan ke dalam klaster yang salah

Nilai paling bagus adalah 1 dan nilai paling jelek adalah -1. Nilai mendekati 0 menunjukkan klaster yang tumpang tindih.

Skor antara 0.0 sampai dengan 1.0. Skor 1.0 menunjukkan labelisasi total

Principal component analysis ( PCA ) adalah prosedur statistik yang menggunakan transformasi ortogonal untuk mengubah seperangkat pengamatan dari variabel yang mungkin berkorelasi (entitas yang masing-masing mengambil berbagai nilai numerik) menjadi seperangkat nilai variabel tidak linear yang disebut komponen utama . Transformasi ini didefinisikan sedemikian rupa sehingga komponen utama pertama memiliki varians sebesar mungkin (yaitu, menyumbang sebanyak variabilitas dalam data mungkin), dan setiap komponen berikutnya pada gilirannya memiliki varians tertinggi yang mungkin di bawah kendala bahwa itu ortogonalke komponen sebelumnya. Vektor yang dihasilkan (masing-masing merupakan kombinasi linear dari variabel dan berisi n pengamatan) adalah himpunan basis ortogonal yang tidak berkorelasi . PCA sensitif terhadap skala relatif dari variabel asli.

PCA ditemukan pada tahun 1901 oleh Karl Pearson , [1] sebagai analog dari teorema sumbu utama dalam mekanika; kemudian dikembangkan secara independen dan dinamai oleh Harold Hotelling pada 1930-an. [2] Bergantung pada bidang aplikasi, ia juga dinamai diskrit Karhunen-Loève (KLT) dalam pemrosesan sinyal , transformasi Hotelling dalam kontrol kualitas multivariat, dekomposisi ortogonal yang tepat (POD) dalam teknik mesin, dekomposisi nilai singular (SVD) ) dari X (Golub dan Van Loan, 1983), dekomposisi nilai eigen (EVD) dari XT X dalam aljabar linier, analisis faktor (untuk diskusi tentang perbedaan antara PCA dan analisis faktor, lihat Bab 7 dari Analisis Komponen Utama Jolliffe ), [3] Eckart-Young theorem (Harman, 1960), atau fungsi ortogonal empiris (EOF ) dalam ilmu meteorologi, dekomposisi fungsi eigen empiris (Sirovich, 1987), analisis komponen empiris (Lorenz, 1956), mode quasiharmonic (Brooks et al., 1988), dekomposisi spektral dalam kebisingan dan getaran, dan analisis modal empiris dalam dinamika struktural.

PCA sebagian besar digunakan sebagai alat dalam analisis data eksplorasi dan untuk membuat model prediksi . Ini sering digunakan untuk memvisualisasikan jarak genetik dan keterkaitan antar populasi. PCA dapat dilakukan dengan dekomposisi nilai eigen dari matriks kovarians data (atau korelasi ) atau dekomposisi nilai singular dari matriks data , biasanya setelah langkah normalisasi data awal. Normalisasi setiap atribut terdiri dari pemusatan rata - rata - mengurangkan setiap nilai data dari rata-rata variabel yang diukur sehingga rata-rata empirisnya (rata-rata) adalah nol - dan, mungkin, menormalkan varian masing-masing variabel agar sama dengan 1; LihatSkor-Z . [4] Hasil PCA biasanya dibahas dalam hal skor komponen , kadang-kadang disebut skor faktor (nilai variabel yang ditransformasikan sesuai dengan titik data tertentu), dan pembebanan (bobot di mana setiap variabel asli standar harus dikalikan untuk mendapatkan skor komponen). [5]Jika skor komponen distandarisasi untuk varians unit, memuat harus berisi varians data di dalamnya (dan itu adalah besarnya nilai eigen). Jika skor komponen tidak distandarisasi (karena itu mengandung varians data) maka pemuatan harus berskala-unit, ("dinormalisasi") dan bobot ini disebut vektor eigen; mereka adalah cosinus dari rotasi orthogonal variabel menjadi komponen utama atau belakang.

PCA adalah analisis multivariat berbasis vektor eigen yang paling sederhana . Seringkali, operasinya dapat dianggap sebagai mengungkapkan struktur internal data dengan cara yang paling menjelaskan perbedaan dalam data. Jika dataset multivariat divisualisasikan sebagai seperangkat koordinat dalam ruang data dimensi tinggi (1 sumbu per variabel), PCA dapat menyediakan gambar dimensi yang lebih rendah kepada pengguna, proyeksi objek ini jika dilihat dari sudut pandang paling informatif [ rujukan? ] . Ini dilakukan dengan hanya menggunakan beberapa komponen utama pertama sehingga dimensi data yang diubah berkurang.

PCA terkait erat dengan analisis faktor . Analisis faktor biasanya memasukkan lebih banyak asumsi spesifik domain tentang struktur yang mendasarinya dan memecahkan vektor eigen dari matriks yang sedikit berbeda.

PCA juga terkait dengan analisis korelasi kanonik (CCA) . CCA mendefinisikan sistem koordinat yang secara optimal menggambarkan cross-covariance antara dua dataset sementara PCA mendefinisikan sistem koordinat orthogonal baru yang secara optimal menggambarkan varians dalam satu dataset. [6] [7]

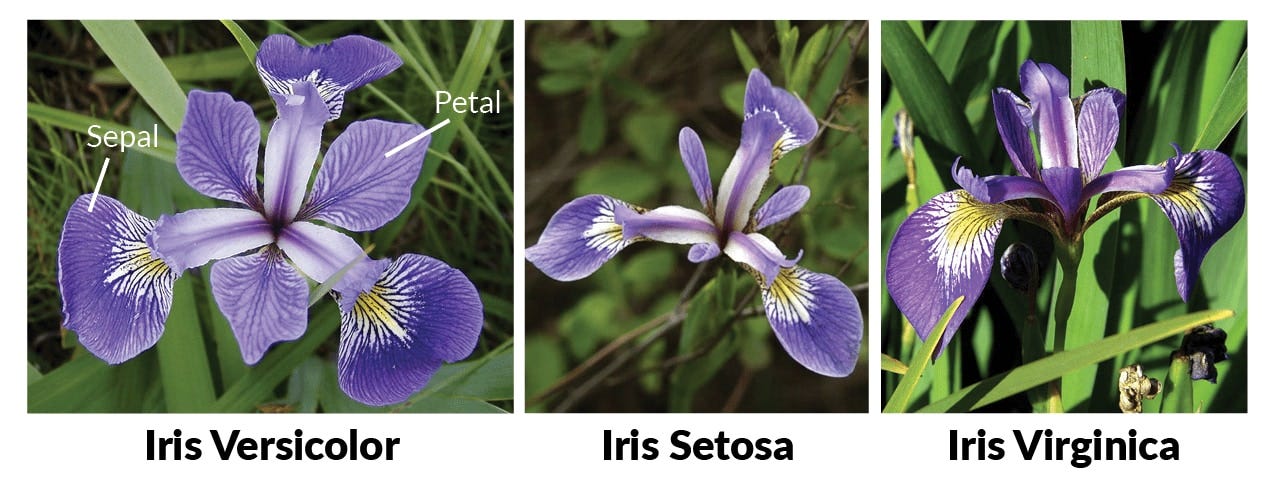

Data bunga Iris dianalisis oleh Ronald Fisher dalam makalahnya tahun 1936 "Penggunaan berbagai pengukuran dalam masalah taksonomi". Data Iris digunakan oleh Fisher sebagai contoh analisis diskriminan linier. Sehingga kadang data bunga Iris disebut juga Fisher Iris Datasets [1]. Kadang datasets ini disebut juga sebagai Iris Anderson karena Edgar Anderson mengumpulkan data untuk menghitung variasi morfologis bunga Iris dari tiga spesies terkait [2]. Dua dari tiga spesies dikumpulkan di Semenanjung Gaspé "semuanya berasal dari padang rumput yang sama, dan dipetik pada hari yang sama dan diukur pada saat yang sama oleh orang yang sama dengan peralatan yang sama" [3].

Set data terdiri dari 50 sampel dari masing-masing dari tiga spesies Iris ( Iris setosa , Iris virginica dan Iris versicolor). Empat fitur diukur dari masing-masing sampel: panjang dan lebar sepal dan kelopak dalam sentimeter. Berdasarkan kombinasi keempat fitur ini, Fisher mengembangkan model diskriminan linier untuk membedakan spesies dari satu sama lain.

Iris setosa (juga dikenal sebagai iris bulu-runcing)

adalah spesies dalam genus Iris , juga dalam subgenus Limniris dan dalam seri Iris Tripetalae . Ini adalah tanaman rhizomatosa abadi dari berbagai wilayah di laut Arktik, termasuk Alaska , Maine , Kanada (termasuk British Columbia , Newfoundland , Quebec dan Yukon ), Rusia (termasuk Siberia ), Asia timur laut, Cina , Koreadan ke selatan ke Jepang. Tanaman ini memiliki batang bercabang tinggi, daun hijau tengah dan ungu, ungu-biru, ungu-biru, biru, hingga bunga lavender. Ada juga tanaman dengan bunga merah muda dan putih.

Iris versicolor

juga dikenal sebagai bendera biru, blueflag harlequin, bendera biru yang lebih besar, bendera biru utara, [1] dan bendera racun, ditambah variasi lain dari nama-nama ini, [2] [3] dan di Inggris dan Irlandia sebagai iris ungu [4].

I. versicolor adalah spesies Iris asli Amerika Utara, di Amerika Serikat bagian Timur dan Kanada Timur . Tumbuh di padang rumput, rawa-rawa, dan sepanjang streambanks dan pantai. Versitet julukan spesifik berarti "berbagai warna". [5]

Iris virginica , dengan nama umum Virginia iris

adalah abadi spesies dari tanaman berbunga , asli Amerika Utara bagian timur. Tumbuh di sepanjang dataran pantai dari Florida ke Georgia di Amerika Serikat Tenggara [2]. Ini adalah salah satu dari tiga spesies Iris dalam data bunga Iris yang ditetapkan oleh Ronald Fisher dalam makalahnya tahun 1936 "Penggunaan berbagai pengukuran dalam masalah taksonomi" sebagai contoh analisis diskriminan linier .

Komponen utama pertama, atau PC1, 'menjelaskan varian paling banyak' dalam dataset asli - ini juga berarti bahwa fitur yang berkorelasi dengan PC1 berkontribusi terhadap sejumlah besar variasi dalam data.

Saat Anda beralih dari PC1 ke PC final, jumlah varians yang dijelaskan berkurang, sedangkan varians yang dijelaskan kumulatif mendekati 100%. Jika Anda ingin mengurangi jumlah dimensi untuk analisis, Anda dapat memilih jumlah PC tertentu berdasarkan pada seberapa banyak variasi dijelaskan (mis. 95%). Anda juga dapat memahami seberapa banyak perbedaan dijelaskan hanya dalam dua atau tiga dimensi yang mudah divisualisasikan.

Saat menganalisis data dengan banyak variabel, saya ingin memahami berapa banyak dan fitur mana yang berguna. Saya bekerja di genomik, di mana Anda dapat dengan mudah memiliki ribuan fitur per instance dan memahami berapa banyak fitur yang saya butuhkan membuatnya lebih mudah untuk melatih dan menafsirkan model pada data itu. Dalam genomik, fitur itu murah dan instansinya berharga. Untuk alasan ini, saya sering menggunakan PCA sebagai panduan untuk memilih fitur mana yang menjadi fokus.